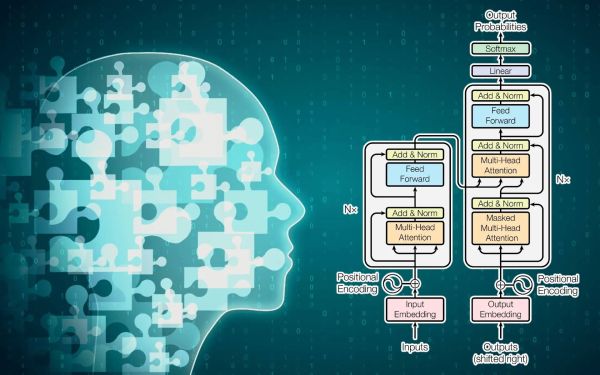

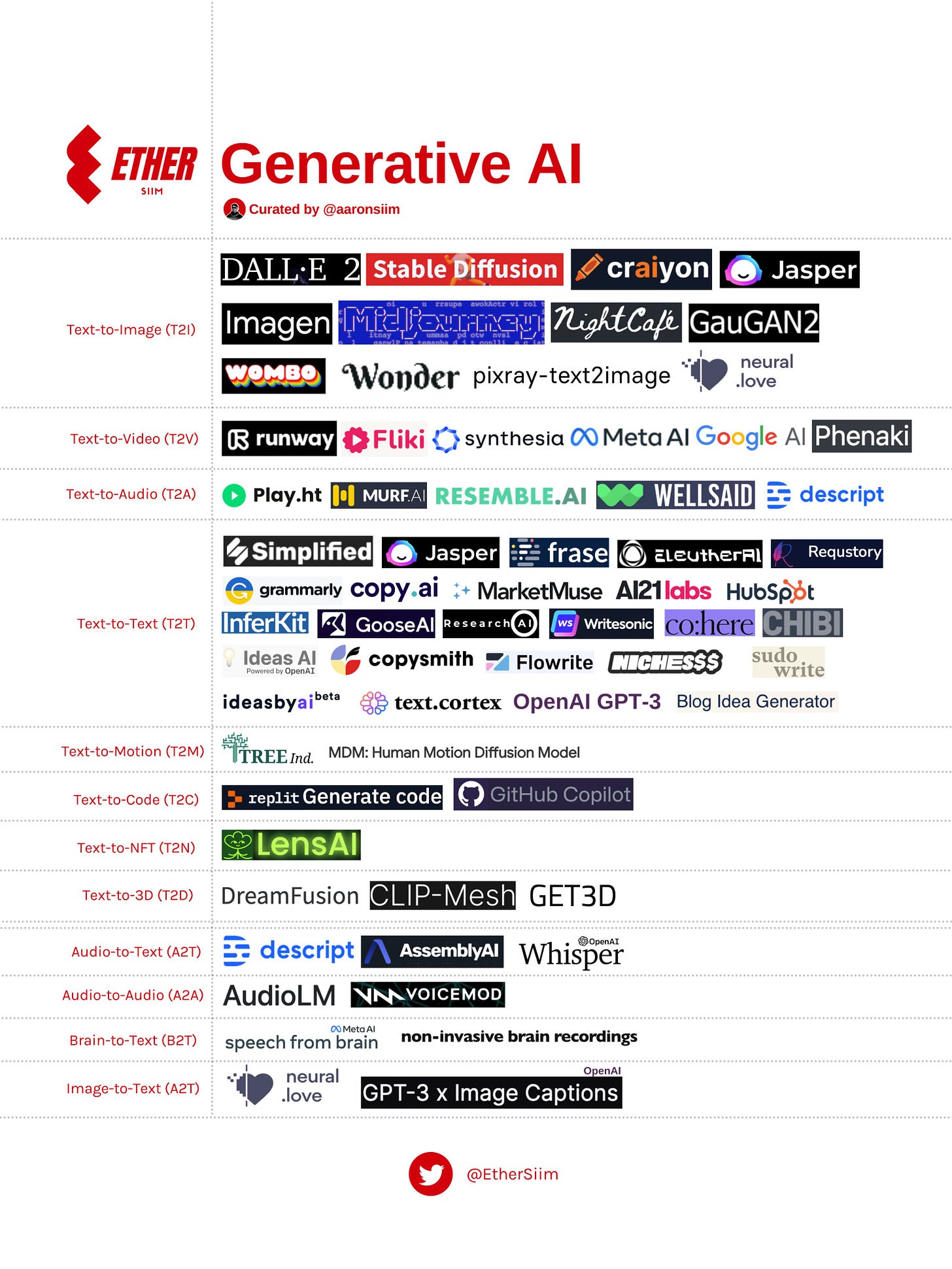

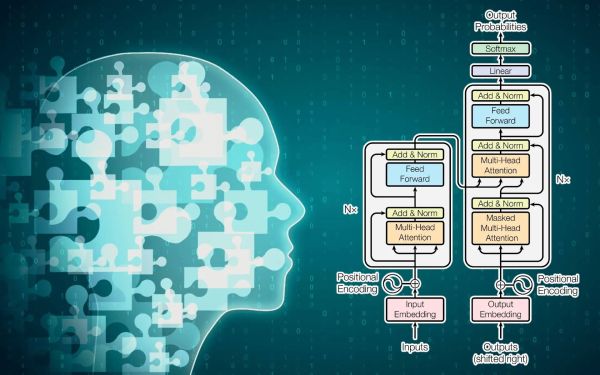

Mi történik a jövőben a mesterséges intelligencia egyik leggyorsabban fejlődő területével, a nagy nyelvmodellekkel (large language models, LLM), a felhasználók csak kevés cég csúcstechnológiái, vagy sokkal több fejlesztő szintén hatékony modelljei közül válogathatnak? – teszi fel a kérdést Andrew Ng, a gépi tanulás egyik abszolút szaktekintélye. Azonnal meg is válaszolja: ugyan az LLM-fejlesztések kezdeti szakaszában járunk, de a felhasználók sok vállalat modelljeihez hozzáférhetnek majd, ami nagyon jót tesz az innovációnak. Egy mai LLM begyakoroltatásához rengeteg adat és komoly infrastruktúra kell, a trendek viszont a szélesebb körű elérhetőséget vetítik előre.

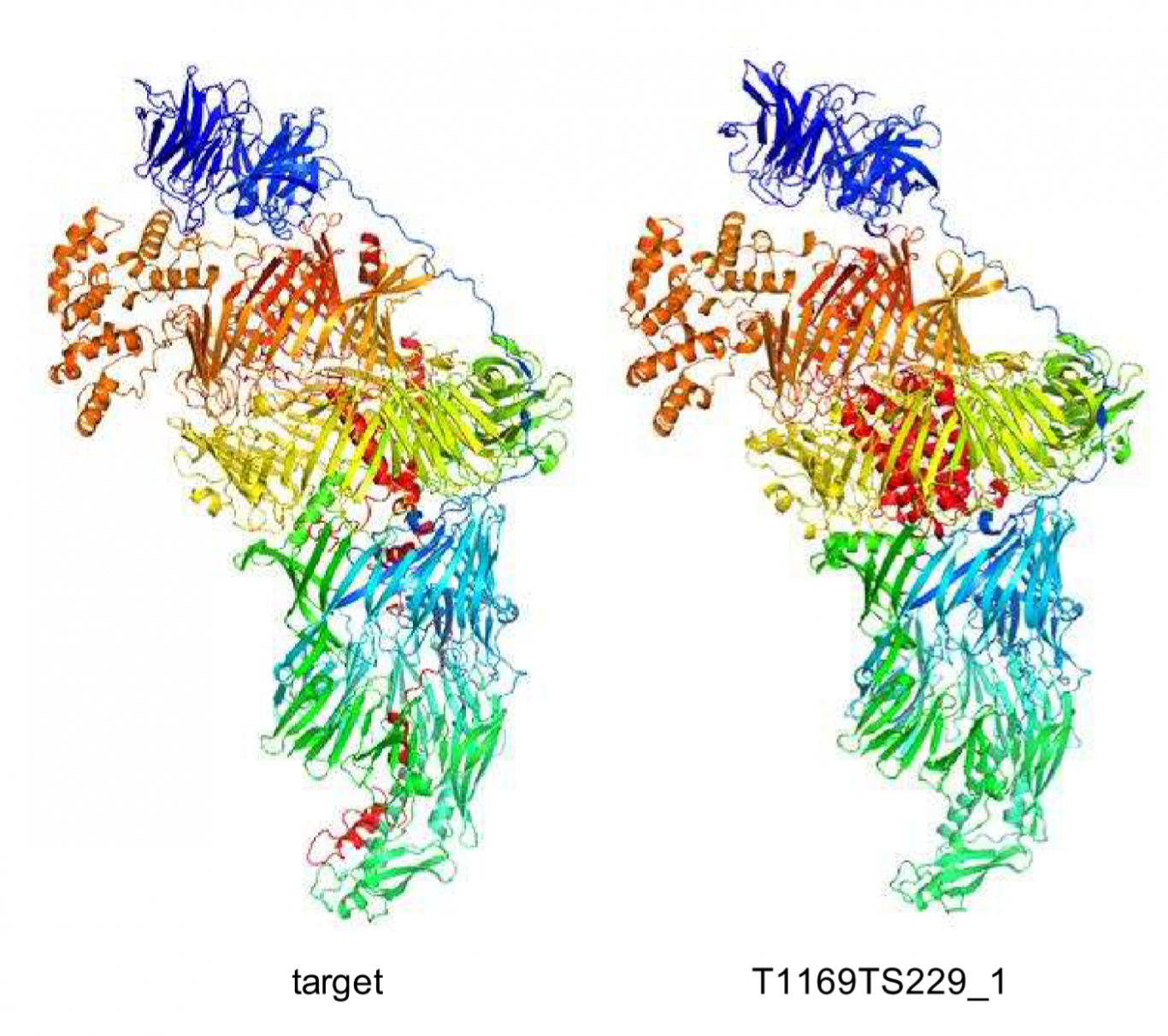

Népszerűvé válnak és egyre jobb teljesítményt nyújtanak a nyílt modellek, mint a Big Science BLOOM-ja, a Tsinghua Egyetem GLM-je és a Meta OPT-je. Az utóbbit a kutatókat bátorító, a kereskedelmi felhasználást viszont kizáró, szigorú licenc alapján tették közzé. A mai nyílt modellek kétségtelenül nem annyira jók, mint egyes cégek szabadalmaztatott darabjai, viszont gyors fejlődés előtt állnak. A kutatók a gyakorlás hatékonyságát növelő technikákat fejlesztenek. A terület egyik élenjárója, a Google-hoz tartozó londoni DeepMind ajánlásokat tett közzé LLM-ek trenírozásáról: hogyan tegyük eredményesebbé őket fix, tehát korlátos költségvetés mellett. Kiderült: akár egyetlen GPU-n (grafikus feldolgozó egységen), egy nap alatt szignifikáns mértékben növelhető egy modell teljesítménye, ráadásul nyolc-, sőt, négy-bites számításokkal is komoly haladás érhető el.

Minél többen fejlesztenek és tesznek közzé nagy nyelvmodelleket, annál szisztematikusabb lesz a költségek, hozzáférhetőség és más feltételek alapján történő kiválasztást segítő összehasonlítás. A felhasználó könnyebben megtalálja, amire tényleg szüksége van. Szerencsére léteznek már kimerítő és pontos összehasonlító LLM-elemzések. Ng többször (Stanford, Google stb.) dolgozott már a legnagyobb rendszerekkel, de aztán mindig jöttek még gyorsabbak, még jobbak. Egy mai LLM esetében rengeteg számítási kapacitás szükséges, de az infokom eddig történelméből egyértelműen kiderül: ez nem lesz mindig így, és inkább előbb, mint utóbb, lényegesen leegyszerűsödik a gyakorlás és a tanulás.

https://jelenbolajovobe.blog.hu/2023/01/17/mi_lesz_a_nagy_nyelvmodellekkel

Kezdőlap

Kezdőlap Cikkek

Cikkek Taglista

Taglista Gy.I.K.

Gy.I.K. Legutóbbi képek

Legutóbbi képek Keresés

Keresés Támogatás

Támogatás Regisztráció

Regisztráció Belépés

Belépés